Intelligence artificielle: évitons son utilisation politique

Une technologie n’est pas bonne ou mauvaise en soi, c’est son utilisation qui l’est. L’intelligence artificielle n’échappe pas à cette règle. Elle est un outil prometteur en termes d’aide à la décision en permettant de simplifier le traitement des données et des informations.

Toutefois, l’IA est parfois vue comme un moyen de révolutionner le système politique et de promouvoir un monde où la décision pourrait être un produit des algorithmes de l’IA. Cette approche se révèle plus que problématique compte tenu des dérives qu’elle engendrerait. En effet, si nous ne faisons pas attention, l’IA peut être un outil de contrôle et de centralisation très efficace qui, entre des mains mal intentionnées, aurait des effets dévastateurs.

Le contrôle des données et des informations : un nouvel enjeu majeur

Les algorithmes sont capables d’identifier les tendances politiques des individus grâce aux regroupements de leurs goûts ou achats sur internet. Comme le mentionne une étude du Future of Humanity Institute de l’université d’Oxford :

Une personne qui n’achète que des aliments végans est statistiquement plus susceptible de soutenir les politiques d’égalité des sexes. Un acteur qui dispose de données sur les achats pourrait alors faire une affirmation probabiliste sur l’inclination politique de cette personne. S’il dispose également d’informations indiquant que la personne s’est trouvée à proximité géographique de l’endroit où se trouve des événements politiques, il peut alors déduire avec une forte probabilité que la personne a de telles opinions.

Cet exemple démontre que même des données non politiques peuvent être utilisées afin de déterminer le profil politique d’une personne.

Dès lors, si l’acteur qui possède ces informations est animé d’intentions politiques, il lui sera facile de détecter ses partisans mais surtout ses adversaires. Et si l’acteur en question est un État, il lui est aisé d’utiliser ces algorithmes pour discriminer et détecter quelle personne est susceptible de lui causer du tort avant même qu’elle agisse.

L’étude citée met en avant que cette stratégie permet à un régime de réprimer de manière plus ciblée et discrète : il est possible d’éviter la propagation d’une opposition en l’étouffant avant qu’elle ne prenne de l’ampleur.

La tentation de la centralisation doit être repoussée : l’exemple chinois

Si cette situation donne l’impression qu’il s’agit d’un scénario d’une œuvre de science-fiction ou d’une dystopie, elle existe pourtant déjà en Chine. Le système de crédit social développé par les autorités chinoises offre un exemple de l’utilisation de l’IA à des fins autoritaires.

Si l’application de ce système est pour l’instant dirigée au niveau local par les provinces et municipalités, il démontre déjà une situation inquiétante pour les libertés quotidiennes des citoyens. En effet, en fonction du comportement du citoyen chinois, ce dernier gagne (par exemple en donnant son sang) ou perd (en promenant son chien sans laisse à Shanghai) des points de crédit social. Un score faible amène des restrictions comme l’interdiction de voyager en avion.

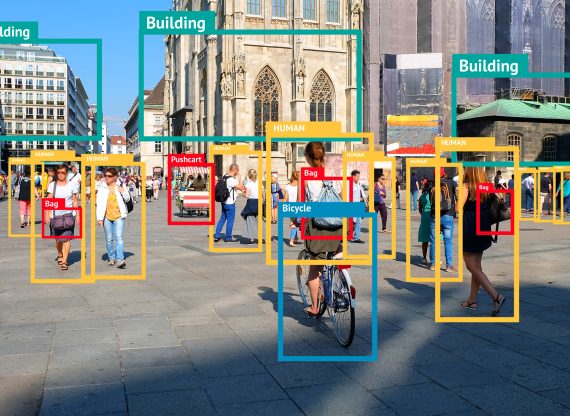

La multiplication de caméras de surveillance et la volonté du gouvernement chinois de centraliser ce système font craindre une accentuation de ce phénomène. Dans ce système, les autorités qui contrôlent ces algorithmes peuvent décider qui est un bon ou un mauvais citoyen à travers des comportements qui ne sont pas illégaux.

Un risque de contagion dans les démocraties

Enfin, il ne faut pas croire qu’une telle stratégie ne pourrait pas percer à terme dans le monde occidental. Rappelons que la surveillance de masse existe déjà dans nos pays : les révélations d’Edward Snowden en 2013, ont montré que la NSA collecte massivement des données personnelles des citoyens américains et étrangers.

De plus, ces derniers mois ont montré une gouvernance très paternaliste. Et des restrictions, qui auraient semblé impensables à mettre en œuvre quelques mois avant, ont été mises en place. Le gouvernement chinois a défendu ce modèle de crédit social en le présentant comme un moyen d’assurer la confiance entre les membres de la société et le bien-être du pays.

Les grandes causes politiques ou les motifs légitimes sont souvent utilisés comme prétextes pour faire passer des mesures liberticides. Il s’agit dès lors d’être vigilant de toute utilisation de l’IA par un acteur en mesure d’avoir de l’autorité sur les individus.

Gaël Campan is Senior Economist at the MEI, Alexandre Massaux is an Associate Researcher at the MEI. The views reflected in this op-ed are their own.